In der heutigen datengetriebenen Welt spielen künstliche Intelligenzen (KI) eine immer größere Rolle bei der Verarbeitung und Analyse von Informationen. Um eine KI effektiv zu trainieren und zu nutzen, benötigt sie Zugang zu umfangreichen und qualitativ hochwertigen Daten. Wissensmanagement-Systeme, wie Atlassian Confluence, sind reich an solchen Daten. Sie enthalten oft das kollektive Wissen und die Expertise eines Unternehmens. Doch wie können wir diese Daten effizient extrahieren, um unsere KI-Systeme zu füttern? Hier kommt das automatisierte Crawlen ins Spiel.

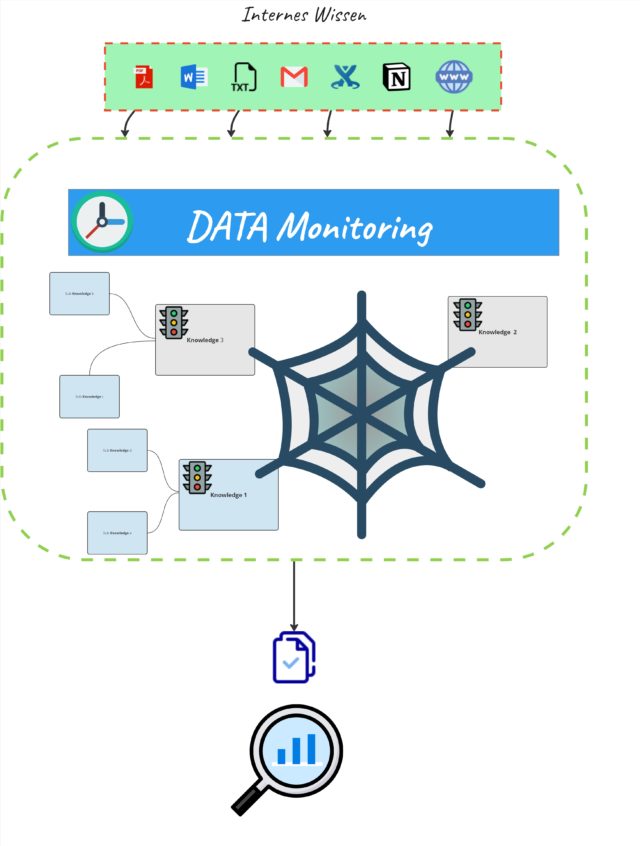

Ein Beispiel eines solchen Aufbaus kann so aussehen

Die Bedeutung des Daten-Crawlens

Daten-Crawling bezeichnet den Prozess des systematischen Durchsuchens von Netzwerken wie dem Internet oder internen Systemen, um Daten zu sammeln. Im Kontext von Wissensmanagement-Systemen bedeutet dies, Informationen aus Artikeln, Diskussionsforen und Dokumentationen zu extrahieren, die dann für das Training von KI-Modellen verwendet werden können.

Herausforderungen beim Crawlen von Wissenssystemen

- Zugriffsrechte und Sicherheit: Viele Wissensmanagement-Systeme enthalten sensible Informationen. Beim Crawlen muss sichergestellt werden, dass nur autorisierte Daten extrahiert werden und die Sicherheitsrichtlinien des Unternehmens eingehalten werden.

- Struktur der Daten: Informationen in Systemen wie Confluence sind oft in einem für Menschen verständlichen Format organisiert, das nicht direkt für Maschinen lesbar ist. Das bedeutet, dass der Crawler in der Lage sein muss, diese Strukturen zu interpretieren.

- Rate Limiting und Performance: Zu aggressives Crawlen kann Systeme überlasten und die Performance für andere Benutzer beeinträchtigen. Es ist wichtig, die Abfrageraten anzupassen und möglicherweise Crawling-Aktivitäten in lastarmen Zeiten durchzuführen.

Best Practices für effektives Crawlen

Respektieren Sie Zugriffsrechte und Datenschutz

Stellen Sie sicher, dass Ihr Crawling-Prozess die Datenschutzbestimmungen und Zugriffsrechte respektiert. Verwenden Sie authentifizierte API-Zugriffe, wenn diese verfügbar sind, und beschränken Sie das Crawlen auf öffentlich zugängliche oder explizit freigegebene Daten.

Auch unternehmensintern gibt es Daten die nicht verwendet werden dürfen. Gerade wenn eine allgemeinen Wissens KI damit trainiert werden soll. Beispiele sind Personalsachen, Informationssicherheits Dokumente und geheime Zusammensetzungen bzw. Produktionsgeheimnisse.

Anpassung an die Datenstruktur

Verwenden Sie fortschrittliche Parsing-Techniken, um die in Wissensmanagement-Systemen gespeicherten strukturierten und unstrukturierten Daten zu extrahieren. Bibliotheken und Frameworks für Natural Language Processing (NLP) können helfen, den Inhalt zu verstehen und zu strukturieren.

Rate Limiting und schonende Ressourcennutzung

Implementieren Sie Mechanismen, um die Rate Ihrer Anfragen zu begrenzen und vermeiden Sie Spitzenbelastungen. Dies schützt nicht nur die Systemressourcen, sondern stellt auch sicher, dass Ihr Crawler nicht durch Sicherheitssysteme blockiert wird.