Die digitale Ära hat eine exponentielle Zunahme an Daten mit sich gebracht, insbesondere in Form von unstrukturierten Texten. Diese unstrukturierten Daten, sei es aus sozialen Medien, Fachartikeln oder Webseiten, enthalten eine Fülle von Informationen, deren Potenzial oft unerschlossen bleibt. Natural Language Processing (NLP), ein Zweig der künstlichen Intelligenz (KI), erweist sich als Schlüsseltechnologie, um aus diesem unstrukturierten Textberg relevantes Wissen automatisch zu extrahieren. In diesem Artikel werfen wir einen Blick auf die Funktionsweise, Anwendungen und Herausforderungen von NLP in diesem Kontext.

Grundlagen des NLP

NLP kombiniert Erkenntnisse aus der Linguistik mit Algorithmen der Informatik, um Maschinen das Verstehen, Interpretieren und Generieren menschlicher Sprache zu ermöglichen. Dies umfasst eine Vielzahl von Techniken, von der Textanalyse bis hin zum Verständnis der Semantik. Die Fähigkeit von NLP, Kontext zu erkennen, Ironie zu verstehen oder sogar Emotionen aus Texten zu extrahieren, macht es zu einem mächtigen Werkzeug.

Ein Kernaspekt von NLP ist die Textextraktion. Hierbei geht es darum, spezifische Daten aus einem Text zu identifizieren und zu extrahieren, wie z.B. Namen von Personen, Orten, Daten oder Fachbegriffe. Diese Technik ermöglicht es, strukturierte Informationen aus unstrukturierten Datenquellen zu gewinnen.

Anwendungen von NLP in der Wissensextraktion

Die Anwendungsgebiete von NLP sind vielfältig und reichen von der automatischen Zusammenfassung von Texten über die Erkennung von Stimmungen (Sentiment Analysis) bis hin zur automatischen Beantwortung von Fragen (Question Answering). Im Kontext der Wissensextraktion ermöglicht NLP beispielsweise:

- Wissensmanagement: Automatische Klassifizierung und Tagging von Dokumenten, um die Suche und das Retrieval von Informationen zu erleichtern.

- Marktforschung: Analyse von Kundenfeedbacks und sozialen Medien, um Einblicke in Kundenmeinungen und -bedürfnisse zu gewinnen.

- Automatische Übersetzung: Erleichterung der globalen Kommunikation durch Übersetzung von Texten zwischen verschiedenen Sprachen.

- Rechts- und Compliance-Überwachung: Identifizierung relevanter Informationen in Verträgen und rechtlichen Dokumenten.

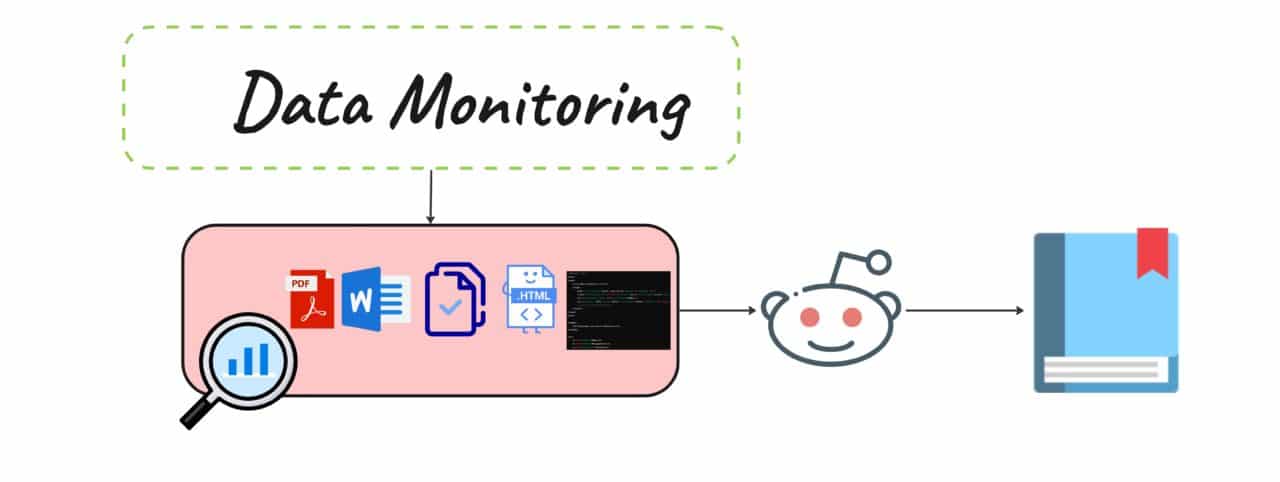

Dabei werden Language Processing Aufgaben automatisiert durchgeführt. Um diesen Schritt starten zu können, müssen die Daten bereits digitalisiert und “maschinenlesbar” sein – also OCR und ICR behandelt.

Technisch gesehen umfasst dieser Prozess mehrere Schlüsselschritte und Technologien, die zusammenarbeiten, um Text zu analysieren, relevante Informationen zu identifizieren und diese in eine strukturierte Form zu bringen, die für weitere Analysen oder Entscheidungsfindungsprozesse genutzt werden kann. Hier ist ein detaillierter Überblick über den Prozess und die Technologien, die in den verschiedenen Phasen der NLP-gestützten Wissensextraktion zum Einsatz kommen:

1. Datenvorbereitung und -reinigung

- Tokenisierung: Zerlegung des Textes in kleinere Einheiten, wie Wörter oder Sätze, um die Analyse zu erleichtern.

- Entfernung von Stoppwörtern: Stoppwörter wie “und”, “oder”, “aber” tragen oft wenig zum Verständnis bei und werden entfernt, um die Effizienz zu steigern.

- Stemming und Lemmatisierung: Reduzierung der Wörter auf ihre Wortstämme oder Grundformen, um die Analysegenauigkeit zu verbessern.

2. Feature-Extraktion und -Vektorisierung

- Bag of Words (BoW): Eine einfache Technik, die die Häufigkeit des Vorkommens von Wörtern in einem Dokument zählt, aber die Reihenfolge ignoriert.

- TF-IDF (Term Frequency-Inverse Document Frequency): Gewichtet Wörter basierend auf ihrer Häufigkeit in einem Dokument im Vergleich zu ihrer Häufigkeit in allen Dokumenten, um die Wichtigkeit von Wörtern zu messen.

- Word Embeddings: Umwandlung von Wörtern in dichte Vektoren, die die semantischen Beziehungen zwischen Wörtern erfassen. Modelle wie Word2Vec, GloVe oder FastText sind hierfür bekannt.

3. Modellierung und Verarbeitung

- Named Entity Recognition (NER): Identifizierung und Klassifizierung von Eigennamen in Texten in vordefinierte Kategorien wie Personen, Organisationen oder Orte.

- Relation Extraction: Erkennung und Klassifizierung der Beziehungen zwischen erkannten Entitäten, um Wissen in Form von Entität-Relation-Entität-Tripeln zu extrahieren.

- Sentiment Analysis: Bestimmung der Meinung oder Stimmung in einem Text, oft verwendet, um Kundenmeinungen oder Markttrends zu analysieren.

- Text Classification: Zuweisung von Textdokumenten zu einer oder mehreren Kategorien basierend auf ihrem Inhalt.

4. Anwendungsspezifische Verarbeitung

Je nach Anwendungsfall können spezifische NLP-Modelle und Techniken angewendet werden:

- Frage-Antwort-Systeme: Verstehen natürlicher Sprache, um Fragen zu beantworten, die auf einem Korpus von Textdokumenten basieren.

- Text Summarization: Automatisches Generieren kurzer Zusammenfassungen großer Texte, um schnell essentielle Informationen bereitzustellen.

- Topic Modeling: Identifizierung der zugrunde liegenden Themen in großen Textmengen.

5. Post-Processing und Wissensintegration

- Data Linking: Verknüpfung der extrahierten Informationen mit bestehenden Wissensdatenbanken oder Ontologien zur Erweiterung des Kontexts und der Verständlichkeit.

- Wissensgraphen: Erstellung von Graphen, die Entitäten und ihre Beziehungen darstellen, um komplexe Beziehungsnetzwerke und Abhängigkeiten zu visualisieren.

Herausforderungen

Trotz der Fortschritte in der NLP-Technologie bleiben Herausforderungen wie die Verarbeitung von Ambiguitäten, die Handhabung von Slang oder spezifischem Jargon, die Erkennung von Ironie oder Sarkasmus, und die Sicherstellung der Genauigkeit über verschiedene Domänen und Sprachen hinweg bestehen.

Die Anwendung von NLP in der Wissensextraktion eröffnet umfassende Möglichkeiten, um unstrukturierte Daten in wertvolles Wissen umzuwandeln. Fortschritte in der KI und maschinellem Lernen, insbesondere durch Deep Learning und Transformer-Modelle wie BERT oder GPT, treiben die Entwicklung in diesem Bereich weiter voran und erweitern die Grenzen dessen, was möglich ist.

Herausforderungen und Zukunftsaussichten

Trotz der beeindruckenden Fortschritte stehen NLP-Anwendungen vor Herausforderungen. Dazu gehören die Bewältigung von Ambiguitäten in der Sprache, die Anpassung an verschiedene Dialekte und Jargons sowie der Schutz der Privatsphäre bei der Verarbeitung sensibler Daten. Zudem erfordert die Training und Implementierung von NLP-Modellen erhebliche Rechenressourcen und Expertise.

Die Zukunft von NLP in der Wissensextraktion sieht jedoch vielversprechend aus. Mit der Weiterentwicklung von Technologien wie Transfer Learning und transformer-basierten Modellen wird NLP immer zugänglicher und effizienter. Dies öffnet die Tür für innovative Anwendungen in einer Vielzahl von Branchen, von der Gesundheitsversorgung über die Finanzdienstleistungen bis hin zur Bildung.

Zusammenfassend lässt sich sagen, dass NLP eine Schlüsselrolle bei der Erschließung des verborgenen Wertes in unstrukturierten Textdaten spielt. Durch die automatische Extraktion von relevantem Wissen ermöglicht NLP Unternehmen und Organisationen, informiertere Entscheidungen zu treffen und neue Erkenntnisse zu gewinnen. Wie wir diese Technologie weiterentwickeln und einsetzen, wird entscheidend dafür sein, wie wir in der Zukunft mit der Flut an Informationen umgehen.