Im digitalen Zeitalter, in dem Podcasts, Videokonferenzen und Sprachnachrichten immer populärer werden, steigt die Bedeutung der automatischen Sprecheridentifikation. Dank fortschrittlicher KI-Technologien ist es nun möglich, verschiedene Sprecher in Audioaufnahmen effizient zu erkennen und zu unterscheiden. In diesem Blogpost erfahren Sie, wie KI zur automatischen Sprecheridentifikation eingesetzt wird und welche Möglichkeiten sich dadurch eröffnen.

Audio Dateien Vorbereiten

Vor der Basis kommt die Vorbereitung. Häufig sind Audiodateien in Video Aufnahmen zu finden. Zusätzlich kann für die Verarbeitung der Dateien auch ein Externer Service genutzt werden. Deswegen lohnt es sich – um die Kosten im Rahmen zu halten – vorher die Dateien auf einer lokalen Umgebung vorzubereiten.

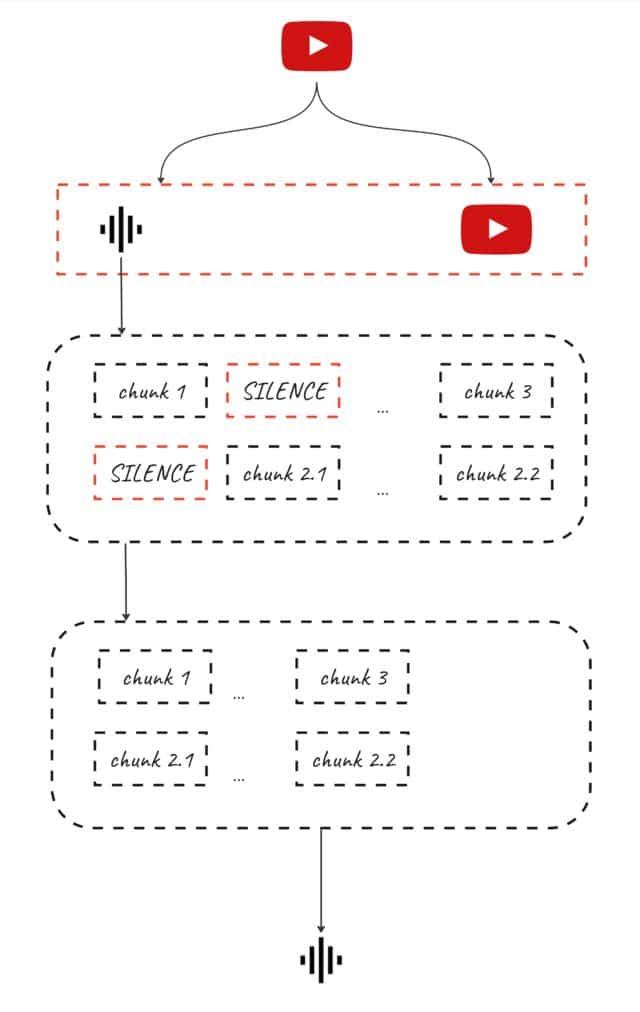

Dazu geht man wie in der Abbildung dargestellt vor.

- Video Datei wird aufgesplittet in Video und Audio

- Audiodatei wird in Chunks aufgeteilt, sodass stille Bereiche, also die in denen nicht gesprochen wird

- diese stillen Stellen werden eliminiert

- Audio wird wieder zusammengeführt

Ein passendes Skript gibt es in meinem Github Repository

https://github.com/JulianFu/audio_cutter

Grundlagen der Sprecheridentifikation

Die Sprecheridentifikation bezieht sich auf den Prozess, individuelle Sprecher in einer Audioaufnahme zu erkennen. Jede menschliche Stimme ist einzigartig und besitzt charakteristische Merkmale wie Tonhöhe, Modulation, Akzent und Sprechgeschwindigkeit. KI-Systeme nutzen diese einzigartigen Merkmale, um Sprecher zu identifizieren.

Einsatz von Machine Learning

Moderne KI-Systeme verwenden Machine Learning, insbesondere Deep Learning-Techniken, um Sprecher zu erkennen. Ein häufig genutzter Ansatz ist die Verwendung von Convolutional Neural Networks (CNNs) oder Recurrent Neural Networks (RNNs), die in der Lage sind, komplexe Muster in den Audiodaten zu erkennen und zu lernen.

Training des Modells

Für eine effektive Sprecheridentifikation muss das KI-Modell mit einer großen Menge an Audiodaten trainiert werden. Diese Daten sollten verschiedene Sprecher, Akzente, Sprachgeschwindigkeiten und Hintergrundgeräusche enthalten, um die Genauigkeit des Modells zu maximieren.

Feature-Extraktion

Ein entscheidender Schritt ist die Extraktion relevanter Merkmale aus den Audiodaten. Dazu gehören spektrale Eigenschaften, Mel-Frequenz-Cepstral-Koeffizienten (MFCCs) und andere akustische Merkmale, die die individuellen Eigenschaften einer Stimme einfangen.

Anwendungsgebiete

Die automatisierte Sprecheridentifikation findet Anwendung in verschiedenen Bereichen, wie etwa in der Sicherheitstechnik für die Authentifizierung, in der forensischen Analyse, bei der Transkription von Meetings oder in intelligenten Assistenzsystemen.

Herausforderungen und Datenschutz

Trotz der Fortschritte gibt es Herausforderungen wie die Handhabung von Hintergrundgeräuschen und die Unterscheidung von sehr ähnlichen Stimmen. Zudem ist es wichtig, Datenschutz und ethische Aspekte zu beachten, insbesondere beim Umgang mit persönlichen Sprachdaten.

Welche Services können dazu verwendet werden?

Microsoft Azure bietet dazu einen passenden Transkriptionsservice an.

Fazit

Die automatisierte Sprecheridentifikation mittels KI bietet faszinierende Möglichkeiten, bringt aber auch Herausforderungen mit sich. Mit fortschreitender Technologie und verbesserter Datenverarbeitung wird sie zunehmend präziser und vielseitiger einsetzbar. Für IT-Experten und Unternehmen eröffnet dies neue Horizonte in der Gestaltung von Audio-Interaktionen und Sicherheitstechnologien.